SLM逆袭LLM?微软下注更小、更便宜的“大模型”大揭秘

1月23日,媒体援引两位知情人士透露。微软已经组建了一个新团队来开发对话式AI,与目前使用的OpenAI软件相比,微软开发的这种AI需要的计算资源更少。知情人士称,微软已将几位顶尖AI开发人员,从其研究小组调至新的GenAI团队。

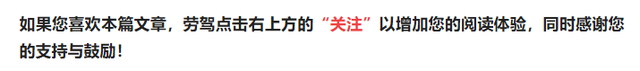

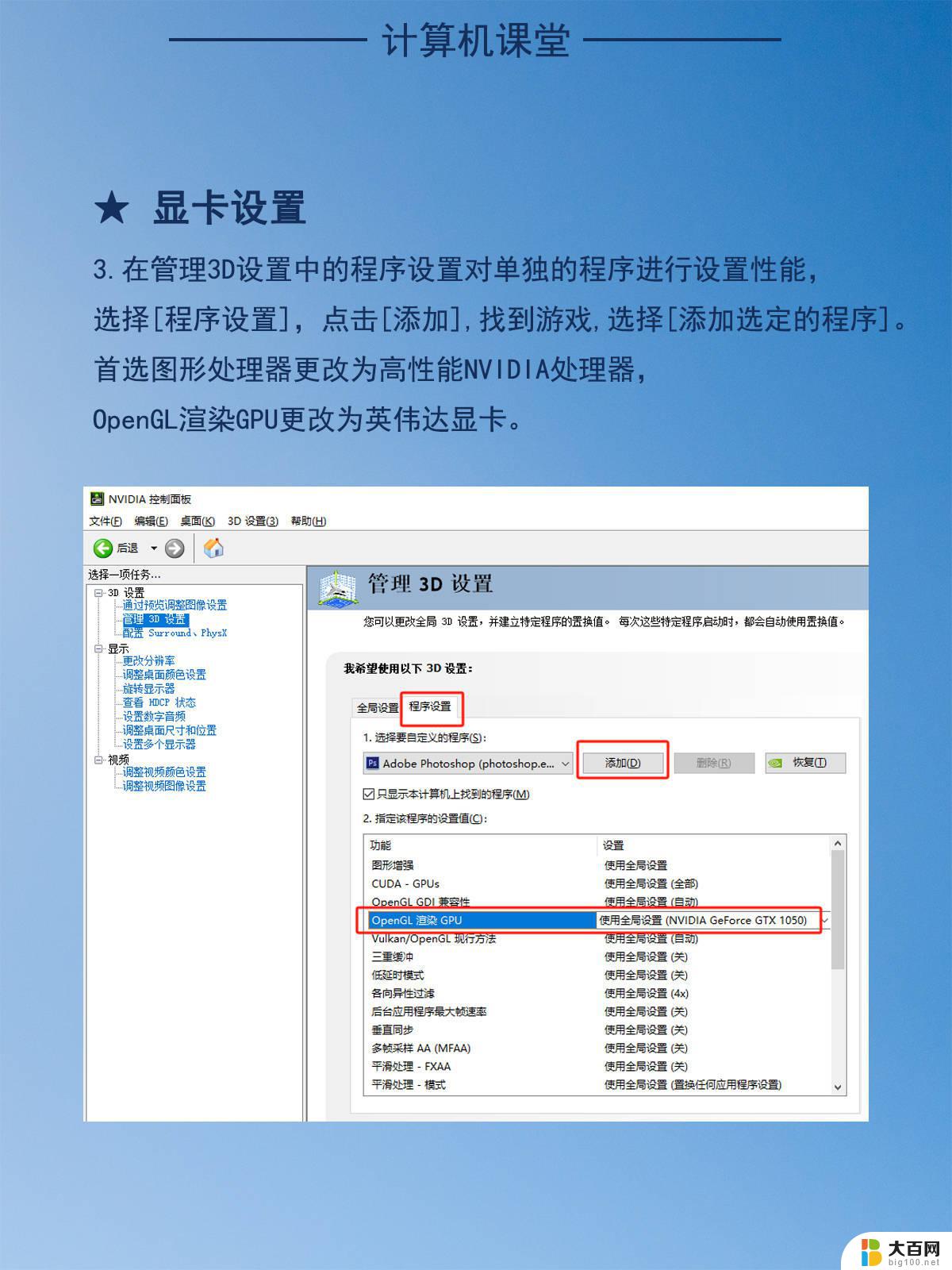

上个月,微软亮出了小模型大招。发布27亿参数规模的小语言模型Phi-2,在部分基准测试中超过谷歌的Gemini Nano 2,可以在笔记本电脑、手机等移动设备上运行。

分析指出,微软与OpenAI的紧密合作。使得GPT模型的表现在大模型市场一骑绝尘,再加上微软参数规模更小的Phi系列,能进一步抢占开源模型长尾市场。

微软大、小模型两手抓

上述知情人士表示,GenAI团队与微软的另一个团队Turing是分开的,Turing开发了大模型来改进Bing和其他微软产品。而GenAI团队致力于开发小模型。

微软的小模型Phi参数规模足够小,但在处理某些任务上可以媲美GPT-4。为了让Phi表现足够优秀,研究人员去年曾使用GPT-4生成了数百万条高质量文本,并根据这些数据对Phi进行了训练。

Phi曾在AI研究社区中引起了轰动,此后,微软又推出该模型的最新版本Phi-2,作为开源模型提供给用它来构建自己的AI应用程序的Azure客户。高盛等公司近几个月就一直在测试Phi。

与此同时,微软已经在研究如何利用小模型,来处理Bing AI聊天机器人和Windows Copilot用户较为基本的咨询问题,以降低计算成本。

本月早些时候,在达沃斯论坛上,微软首席执行官Satya Nadella夸赞了公司在小模型方面的工作,称其为“掌控我们自己命运”的一种方式。

Nadella表示:"我们对拥有最好的前沿模型非常重视,当前最先进的大模型是GPT-4。我们还有Phi,它是微软最好的小模型。因此,我们将拥有多样化的模型。”

“小模型”开辟新战场

除了微软之外,也是在上个月,法国初创公司MistralAI公布的开源模型Mixtral 8x7B引起轰动。

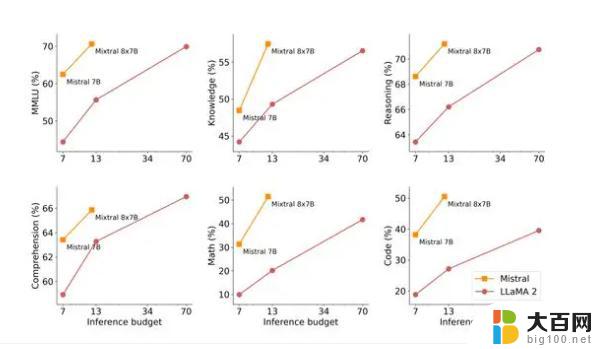

华尔街见闻此前文章提到,模型Mixtral 8x7B规模参数相对较小,而能力却能达到GPT-3.5的水平。

Mixtral 8x7B之所以叫Mixtral 8x7B,是因为它属于稀疏模型,将各种为处理特定任务而训练的较小模型组合在一起,从而提高了运行效率。

性能方面,Mixtral表现优于Llama 2 70B,推理速度提高了整整6倍;在大多数标准基准测试上与GPT-3.5打平,甚至略胜一筹。

成本方面,由于Mixtral的参数较小,所以其成本也更低。与Llama 2相比,Mixtral 8x7B表现出自己高能效的优势。

毫无疑问,规模较小的模型可以降低了大规模运行人工智能应用的成本,同时极大地拓宽了生成式AI技术的应用范围。

值得一提的是,MistralAI刚刚完成4.15亿美元融资,最新估值已经冲破20亿美元,在短短6个月中增长了7倍多。

本文来自华尔街见闻,欢迎下载APP查看更多